我们知道pytorch的机器学习代码是可以放在显卡上面运行的(很多情况下也都是放在显卡上运行),而且机器学习的代码也是显卡资源占用大户。那么pytorch怎么查看占用的GPU资源呢?又该如何释放已关闭程序占用的资源呢?接下来这篇文章告诉你。

看代码吧~

import torch

print(torch.cuda.current_device())

print(torch.cuda.device_count())

print(torch.cuda.get_device_name())

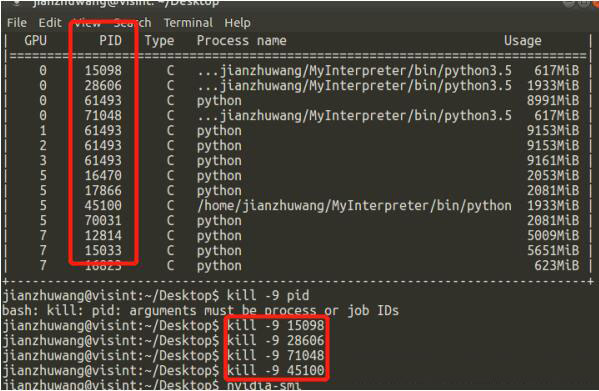

print(torch.cuda.is_available())打开terminal输入nvidia-smi可以看到当前各个显卡及用户使用状况,如下图所示,使用kill -9 pid(需替换成具体的编号)即可杀掉占用资源的程序,杀完后结果如下图所示,可以发现再也没有对应自己的程序了!

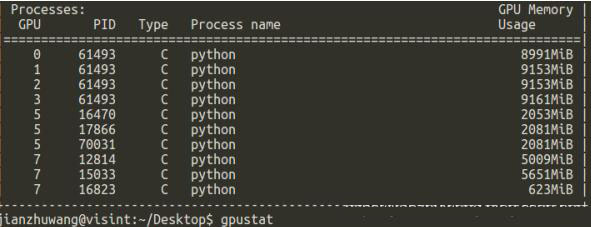

补充一下师弟帮忙的记录截图,方便以后查询使用:

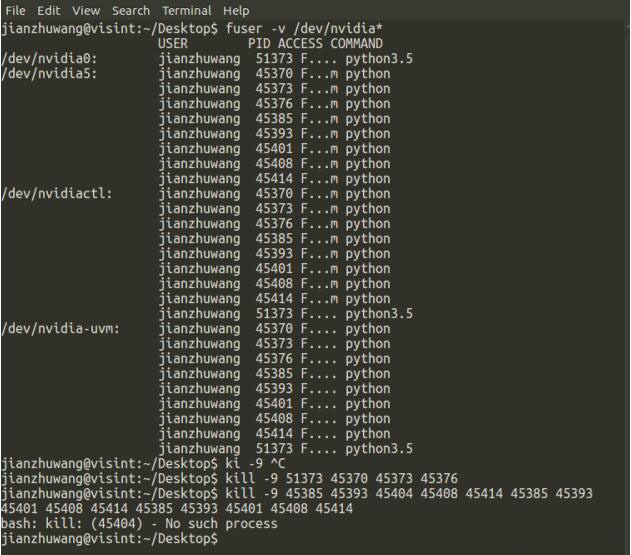

补充:如何处理Pytorch使用GPU后仍有GPU资源未释放的情况

使用PyTorch设置多线程(threads)进行数据读取(DataLoader),其实是假的多线程,他是开了N个子进程(PID都连着)进行模拟多线程工作,所以你的程序跑完或者中途kill掉主进程的话,子进程的GPU显存并不会被释放,需要手动一个一个kill才行

具体方法描述如下:

1.先关闭ssh(或者shell)窗口,退出重新登录

2.查看运行在gpu上的所有程序:

fuser -v /dev/nvidia*

3.kill掉所有(连号的)僵尸进程

以上就是pytorch怎么查看占用的GPU资源的方法,希望能给大家一个参考,也希望大家多多支持W3Cschool。

免费 AI IDE

免费 AI IDE